Суть вопроса

Имеется гипервизор(Proxmox VE 5.4, серверное железо, система установлена на одиночный SAS HDD ST3146356SS), и 3 пары носителей- SSD Kingston SEDC400S37/480G

- HDD SATA2, 7200rpm WD3201ABYS

- HDD SAS 15000rpm ST3300657SS (LSI 9260-4i)

Избыточность предполагается обеспечить путем репликации ZFS snapshots.

Задача

Провести сравнительный тест быстродействия дисковой подсистемы с целью получения максимального быстродействия - предпологаемый результат очевиден, но хочется знать порядок разницы.

Стенд и порядок проведения теста

В качестве стендовой VM будет использоваться VM: W2008R2, 4CPU KVM64, 8Gb RAM, 32Gb virtio HDD без кэша.

Для каждого типа носителей с помощью программы Crystal Disc Mark v6 будет выполнен тест при расположении ZFS pool на одиночном носителе и на raid0 (stripe), для SAS дисков будет также протестирован stripe raid собранный средствами контроллера LSI MR9260-4i.

Тест базовый

Тест HDD SATA2, 7200rpm WD3201ABYS

Тест HDD SAS 15000rpm ST3300657SS (LSI 9260-4i)

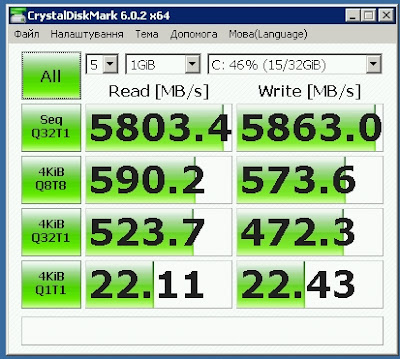

Тест SSD Kingston SEDC400S37/480G

- ZFS pool на single disk

- ZFS pool raid0

Какие выводы напрашиваются при взгляде на странные (на первый взгляд) результаты тестирования?

- Надо отдавать себе отчет, что мы протестировали не хранилище, а блочное устройство, расположенное в хранилище.

- Физический сервер обладал по отношению к виртуальной машине избыточностью по некоторым параметрам в 30-40 раз, поэтому правильнее было проводить тест, запустив его одновременно на 10-20 подобных виртуалках.

- При миграции образа VM из одного хранилища в другое демонстрировалось быстродействие, ожидаемое от типа хранилища.

- Результаты для аппаратного и програмного рейда из тех же дисков демонстрируют правоту тех, кто призывает к отказу от аппаратных рейдов.

- Ни в коем случае не нужно использовать для VM хранилище на общем с системой диске

- Для хранилища следует предпочесть ZFS а не LVM

P.S.

В ходе эксперимента пулы создавались коммандой

zpool create -f pool[n] /dev/sd[a] /dev/sd[b]

а удалялись коммандой

Выполненными в веб оболочке zpool destroy pool[n]

Немає коментарів:

Дописати коментар